| M. Michel CABANE | Président |

| M. Pierre DROSSART | Rapporteur |

| M. Ray PIERREHUMBERT | Rapporteur |

| M. Patrick MASCART | Rapporteur |

| M. Alain HAUCHECORNE | Examinateur |

| M. Daniel GAUTIER | Examinateur |

| M. Olivier TALAGRAND | Examinateur |

Travaux réalisés :

au Laboratoire de Météorologie Dynamique du CNRS

Institut Pierre Simon Laplace

NOLOGO

Un grand merci d'abord aux étudiants que j'ai eu le plaisir d'encadrer ces dernières années et qui ont contribué à des titres divers à l'avancée des travaux présentés ici. Plutôt que de les nommer dans ce préambule, je les ai mentionnés au fil des chapitres. Beaucoup de ces étudiants ont depuis trouvé leur place, dans la recherche ou ailleurs, mais quelques uns sont venus malheureusement grossir durablement les bataillons de la précarité que nous avons laissé prospérer autour de nos instituts de recherche.

Merci ensuite aux collègues qui gravitent autour du noyau dur du "LMD-Jussieu" et avec qui nous avons construit au fil des ans un environnement de travail sérieux et néanmoins fort sympathique sans lequel ce travail n'aurait pas été possible. Quand je pense à cet environnement, me vient souvent l'image d'une niche écologique où compétences (depuis la physique fondamentale jusqu'au secrétariat), intelligence et originalité s'additionnent dans la bonne humeur, à l'abri du carriérisme et de la surenchère programmatique et technocratique qui semblent le lot quotidien de la recherche "moderne" ; où l'on sait encore qu'avant d'aller jouer les moulins à vent de mitinges en projets européens, il faut avoir du grain à moudre et donc commencer par labourer, semer, moissonner. Alors, à vous tous qui vous reconnaîtrez, un immense merci.

Je veux enfin remercier ceux des responsables qui m'ont épaulé à un moment ou un autre au cours de ces travaux. Comme ils auront peut-être plus de difficulté à se reconnaître, je citerai en particulier Olivier Talagrand, Jean-Paul Huot, Gérard Mégie, Sylvie Joussaume, Hervé Le Treut et Claude Basdevant. Merci enfin aux voyageurs, proches ou lointains, qui ont accepté de participer au jury.

Deux objectifs, en partie contradictoires, m'ont guidé dans la rédaction de ce document. Le premier est d'ordre statutaire : pour soutenir une Habilitation à Diriger des Recherches, il faut rédiger une synthèse de ses travaux antérieurs, souvent déjà publiés en anglais dans des revues à comité de lecture. Le second objectif que je me suis fixé est de profiter de cet exercice imposé pour essayer d'écrire un texte qui puisse servir plus ou moins directement de support de travail pour des collègues, voir de support pédagogique sur différents sujets auxquels je me suis intéressé au cours des dix dernières années. Faute d'avoir pu y consacrer suffisamment de temps, ces objectifs ne sont certainement que partiellement atteints. Les rapporteurs et examinateurs ne manqueront pas de trouver le document trop long. Les collègues ou étudiants voulant se renseigner sur un des sujets abordés le trouveront incomplet ou elliptique ; déséquilibré entre des parties trop techniques et d'autres trop vagues. J'espère que l'exercice restera malgré tout utile. Parmi les efforts pour accroître la lisibilité, j'ai essayé de réduire au maximum le nombre des acronymes utilisés et de répertorier en fin de document ceux qui sont utilisés.

Le texte est composé de quatre parties plus ou moins indépendantes, avec à chaque fois une introduction assez complète et des conclusions et perspectives. L'introduction et la conclusion du document sont donc plutôt là pour brosser le cadre général du travail pour l'une et tracer des perspectives générales pour l'autre. Le fil conducteur de ces différentes parties est le transport atmosphérique et la modélisation de ce transport dans les modèles globaux de climat.

Les couplages entre composition et transport atmosphérique occupent une place grandissante dans l'étude des atmosphères planétaires.

Ces couplages sont tout d'abord au centre d'une partie des questions

relatives au changement climatique.

En effet,

une part des incertitudes

relatives au réchauffement global du climat terrestre provient

des incertitudes sur l'évolution de la

composition même de l'atmosphère (CO![]() , méthane, ozone troposphérique,

aérosols).

Or l'évolution de cette composition est étroitement liée au

transport atmosphérique et au climat.

Pour le CO

, méthane, ozone troposphérique,

aérosols).

Or l'évolution de cette composition est étroitement liée au

transport atmosphérique et au climat.

Pour le CO![]() , l'augmentation des concentrations atmosphériques

sous l'effet des émissions anthropiques conduit à une augmentation

du stockage dans les océans et les écosystèmes.

Le puits biosphérique est lui-même sensible à l'évolution

du climat. Les estimations actuelles prévoient une réduction du

puits biosphérique consécutive au changement climatique qui

pourrait correspondre

à une rétroaction positive de 15

, l'augmentation des concentrations atmosphériques

sous l'effet des émissions anthropiques conduit à une augmentation

du stockage dans les océans et les écosystèmes.

Le puits biosphérique est lui-même sensible à l'évolution

du climat. Les estimations actuelles prévoient une réduction du

puits biosphérique consécutive au changement climatique qui

pourrait correspondre

à une rétroaction positive de 15![]() sur la teneur en CO

sur la teneur en CO![]() de l'atmosphère

(Dufresne, 2002).

La modification de l'ozone troposphérique est également étroitement

couplée à l'évolution de la température et de l'humidité.

Les changements des vents en surface peuvent également modifier le soulèvement

des poussières désertiques

ou les émissions de DMS (précurseurs des aérosols soufrés)

par les océans (Bopp et al., 2004).

de l'atmosphère

(Dufresne, 2002).

La modification de l'ozone troposphérique est également étroitement

couplée à l'évolution de la température et de l'humidité.

Les changements des vents en surface peuvent également modifier le soulèvement

des poussières désertiques

ou les émissions de DMS (précurseurs des aérosols soufrés)

par les océans (Bopp et al., 2004).

Au-delà des modifications de la composition, la sensibilité du climat à un changement de concentration imposé est également souvent conditionnée par des processus de transport. La fameuse rétroaction vapeur d'eau (l'atmosphère plus chaude se charge en vapeur d'eau, ce qui augmente en retour l'effet de serre) peut par exemple être fortement modulée par les processus de transport. Si on suppose par exemple que le réchauffement résulte également en une augmentation de l'altitude de la pénétration de la convection (convection nuageuse ou grands systèmes de Hadley-Walker), l'air subsident autour de ces zones convectives sera au contraire plus sec. Même si les processus de transport sont plus complexes (cf. par exemple Pierrehumbert, 1998), il n'en reste pas moins que l'accroissement d'humidité lors d'un réchauffement climatique peut être modulé par les changements d'advection. Les effets indirects des aérosols (une augmentation du nombre de noyaux de condensation résultant en des nuages formés de plus petites gouttes, donc plus brillants et moins précipitants) sont également une source importante d'incertitude sur l'amplitude du changement climatique, étroitement liée au transport et à la microphysique.

Concernant les couplages entre composition et dynamique atmosphérique sur les

autres planètes, on mentionnera d'abord le cas des poussières sur Mars.

En dehors des bandes d'absorption du CO![]() , constituant majoritaire

de la fine atmosphère martienne, la poussière est le principal constituant

actif radiativement. Cette poussière est en permanence soulevée du sol du

grand désert martien

par des rafales de vent, des tornades ou de petites tempêtes locales.

Régulièrement, des tempêtes

plus importantes se déclenchent, soulevant la poussière sur des milliers

de kilomètres. A certaines périodes de l'année, ces tempêtes peuvent

finalement dégénérer en évènements globaux spectaculaires, au cours desquels

la surface de Mars est entièrement voilée pour l'

, constituant majoritaire

de la fine atmosphère martienne, la poussière est le principal constituant

actif radiativement. Cette poussière est en permanence soulevée du sol du

grand désert martien

par des rafales de vent, des tornades ou de petites tempêtes locales.

Régulièrement, des tempêtes

plus importantes se déclenchent, soulevant la poussière sur des milliers

de kilomètres. A certaines périodes de l'année, ces tempêtes peuvent

finalement dégénérer en évènements globaux spectaculaires, au cours desquels

la surface de Mars est entièrement voilée pour l'![]() il

d'un observateur extérieur. La circulation est alors profondément modifiée

(Hourdin et al., 1993).

Notons enfin les

couplages entre la photochimie, la microphysique des brumes et la

circulation stratosphérique sur Titan qui ont largement retenu notre attention

au cours des années passées et qui font l'objet d'un chapitre du présent

document.

il

d'un observateur extérieur. La circulation est alors profondément modifiée

(Hourdin et al., 1993).

Notons enfin les

couplages entre la photochimie, la microphysique des brumes et la

circulation stratosphérique sur Titan qui ont largement retenu notre attention

au cours des années passées et qui font l'objet d'un chapitre du présent

document.

La modélisation numérique globale est devenue un outil de base pour aborder ces systèmes complexes. Les modèles de circulation générale atmosphérique, développés au début des années 70 pour les besoins de la prévision météorologique, se sont petit à petit enrichis tant sur le plan physique (représentation des nuages, modèles thermodynamiques du sol, paramétrisation de la convection) que par la prise en compte du couplage avec les autres composantes du système climatique. On pense en particulier pour la Terre au couplage avec l'océan, la végétation, la chimie ou les aérosols. Ces développements ont abouti dans les années récentes au concept de ``modèles intégrés du climat" (les soi-disant ``Earth system models") utilisés notamment pour essayer de prévoir les évolutions futures du climat. Un modèle de ce type est actuellement développé et utilisé à l'IPSL. Il comprend, couplé au modèle de circulation générale atmosphérique LMDZ, le modèle de circulation générale océanique ORCALIM, le modèle des surfaces continentales ORCHIDEE et le module aérosols-chimie INCA. Ce modèle est actuellement impliqué dans la réalisation de ``scénarios climatiques" pour le prochain rapport du GIEC.

Une des originalités de la recherche menée au LMD est d'étudier

de front et avec le même outil, LMDZ, le climat de la Terre et celui

d'autres planètes du système solaire, en particulier Mars

et Titan.

En parallèle du développement du modèle intégré terrestre, et souvent

même avant, les versions planétaires ont connu des évolutions similaires.

Sur Mars, ce sont les couplages avec le cycle du

carbone (un quart de l'atmosphère de CO![]() se condense saisonnièrement

dans les calottes polaires), des poussières (on en a parlé plus haut)

et de l'eau (avec l'enjeu de déterminer les réservoirs d'eau sous la surface

et de comprendre les évolutions passées du climat de la planète rouge) qui

ont été inclus dans les modèles de circulation existants

(Forget et al., 1998; Montmessin, 2004; Hourdin et al., 1995a,1993).

Pour Titan, les couplages avec la photochimie et la brume

(Lebonnois et al., 2003b; Rannou et al., 2002; Hourdin, 2004) ou le méthane (Tokano, 2001) ont

également été inclus dans les modèles existants.

se condense saisonnièrement

dans les calottes polaires), des poussières (on en a parlé plus haut)

et de l'eau (avec l'enjeu de déterminer les réservoirs d'eau sous la surface

et de comprendre les évolutions passées du climat de la planète rouge) qui

ont été inclus dans les modèles de circulation existants

(Forget et al., 1998; Montmessin, 2004; Hourdin et al., 1995a,1993).

Pour Titan, les couplages avec la photochimie et la brume

(Lebonnois et al., 2003b; Rannou et al., 2002; Hourdin, 2004) ou le méthane (Tokano, 2001) ont

également été inclus dans les modèles existants.

Pour la modélisation des couplages entre composition et climat,

une étape essentielle du travail de développement

consiste à introduire, dans le modèle de circulation générale atmosphérique,

les algorithmes permettant de représenter le transport des espèces traces.

Il faut traiter à la fois le transport par l'écoulement explicitement représenté

dans le modèle de circulation (c'est à dire pour des échelles supérieures

à quelques centaines ou dizaines de kilomètres) et le transport

par les écoulements non résolus, turbulents ou convectifs.

C'est en fait l'introduction, dans le modèle LMDZ,

de schémas permettant de représenter le transport à grande échelle

qui a donné le coup d'envoi à l'ensemble des études présentées ici.

Nous avons plus particulièrement mis en ![]() uvre dans le modèle LMDZ

des schémas en volumes finis développés

à l'origine par Van Leer (1977).

Les versions terrestre et planétaires étant développées de front,

ce travail d'introduction du transport a été effectué de fait

à la fois pour la Terre, Mars et Titan.

Cette version avec transport des traceurs du modèle LMDZ est à l'origine d'un

grand nombre de développements et applications concernant ces trois planètes.

Ce travail préliminaire est décrit dans le Chapitre 2.

uvre dans le modèle LMDZ

des schémas en volumes finis développés

à l'origine par Van Leer (1977).

Les versions terrestre et planétaires étant développées de front,

ce travail d'introduction du transport a été effectué de fait

à la fois pour la Terre, Mars et Titan.

Cette version avec transport des traceurs du modèle LMDZ est à l'origine d'un

grand nombre de développements et applications concernant ces trois planètes.

Ce travail préliminaire est décrit dans le Chapitre 2.

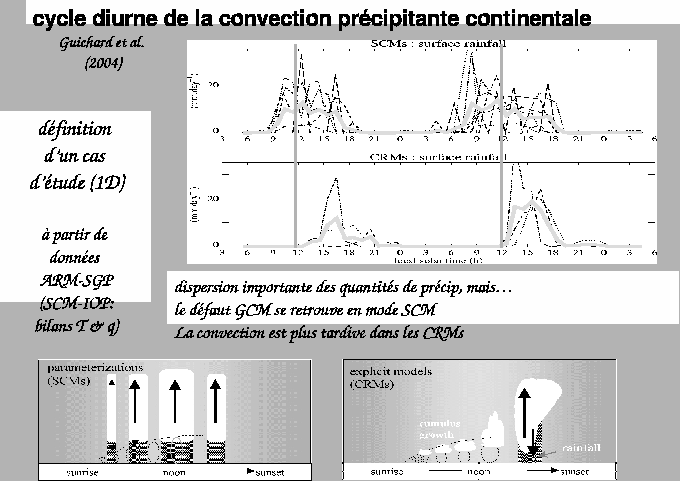

Je me suis ensuite plus particulièrement intéressé au transport vertical par les structures méso-échelles de la couche limite convective. Ces structures (rouleaux, cellules thermiques), bien connues des amateurs de vol libre (deltaplanes, planeurs, parapentes), ne sont en général pas considérées de façon spécifique dans les modèles de circulation globaux, qui privilégient, à un bout, une vision en diffusion du transport turbulent dans la couche limite et, à l'autre bout, des schémas de convection profonde, contrôlés pour une bonne part par les changements de phase de l'eau. Les modèles doivent du coup inclure des traitements adhoc (``contre-gradients", ``ajustement convectif") pour pallier l'absence de paramétrisation des structures convectives de couche limite ; ces structures convectives qui, sur des régions désertiques ou sur une planète-désert comme Mars, peuvent dominer le transport vertical jusqu'à plusieurs kilomètres au-dessus de la surface. Cette nouvelle paramétrisation, le ``modèle du thermique", basée sur une formulation dite ``en flux de masse", est décrite en détail dans le Chapitre 3. Y sont également présentées différentes validations par rapport à des simulations numériques des grands tourbillons ou à des observations.

En marge des questions relevant directement des couplages entre composition et climat, les outils développés pour le transport des espèces traces peuvent être utilisés pour étudier la dispersion de polluants atmosphériques à écoulement atmosphérique connu. On présente dans les chapitres 2 et 3 de tels calculs de dispersion, réalisés ici à des fins de validation des algorithmes de transport. Dans ces simulations numériques, on force le modèle de circulation atmosphérique à suivre au plus près la situation synoptique afin de comparer, au jour le jour, les concentrations observées de certains constituants avec des données de terrain. La technique employée est baptisée ``nudging" en Anglais ce qu'on traduira ici par ``guidage". Cette technique consiste à relaxer en permanence les champs météorologiques du modèle vers des données d'``analyses" ou ``réanalyses" produites par les grands centres de prévisions météorologiques. Dans ce cas, le modèle de circulation joue le rôle d'une espèce d'interpolateur physique sur le maillage choisi et permet de recalculer un jeu cohérent de grandeurs physiques nécessaires à la représentation du transport grande échelle et sous-maille. Les grandeurs nécessaires pour les algorithmes de transport des traceurs peuvent être soit passées directement aux algorithmes concernés, soit stockées dans des fichiers puis relues pour le seul calcul du transport des espèces traces. On parlera de modes ``branché" et ``débranché".

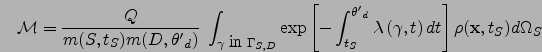

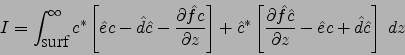

Il s'avère que le modèle guidé et débranché, développé à l'origine pour des besoins de validation dans le cadre des études couplées chimie-climat, est un modèle global de dispersion atmosphérique parfaitement adapté à certaines questions relatives à la surveillance de l'environnement. Un travail spécifique a été entrepris dans ce domaine suite à une demande du CEA relative à la surveillance des essais nucléaires à partir de la mesure de la concentration en éléments radioactifs. Il s'agit d'un cas classique de problème inverse dans lequel on veut obtenir des contraintes sur les sources à partir de mesures de concentration. Avec Robert Sadourny, nous nous sommes convaincus, à l'époque de la demande, qu'il était légitime, pour répondre à cette question, d'inverser la direction du temps dans le modèle de transport Eulérien (débranché). En émettant un traceur au niveau des détecteurs, le modèle calcule alors la distribution d'origine de l'air échantillonné à la station.

L'utilisation du transport inverse et de ``modèles de détecteurs" pour aborder ce type de question n'est pas nouvelle. Mais le fait qu'on puisse utiliser directement les codes Eulériens à rebours dans le temps (ce que nous appellerons le ``rétro-transport Eulérien'') ne semblait pas vraiment acquis. Ce travail sur la détection des essais nucléaires a donc été l'occasion de clarifier la théorie sous-jacente. Le rétro-transport Eulérien peut être présenté d'un point de vue physique comme une formulation Eulérienne de l'approche des rétro-trajectoires Lagrangiennes, largement utilisée dans la communauté des chimistes de l'atmosphère pour interpréter des mesures de composition ponctuelles. Le rétro-transport Eulérien peut également être présenté d'un point de vue mathématique comme l'adjoint du transport direct pour un produit scalaire particulier, pondéré par la masse de l'air sous-tendant le transport. Les visions à la base des rétro-trajectoires et de l'approche adjointe sont cependant suffisamment différentes pour que les outils développés le soient aussi, avec des conséquences importantes sur l'efficacité des algorithmes d'inversion. Le Chapitre 4 présente de façon détaillée à la fois les aspects théoriques, des illustrations numériques et des exemples d'application pour la surveillance des essais nucléaires. Les outils développés à cette occasion sont en cours d'intégration dans une chaîne opérationnelle au CEA.

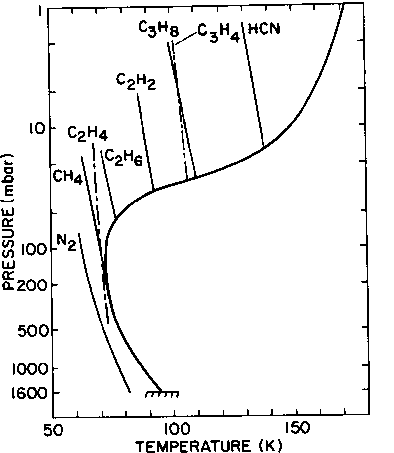

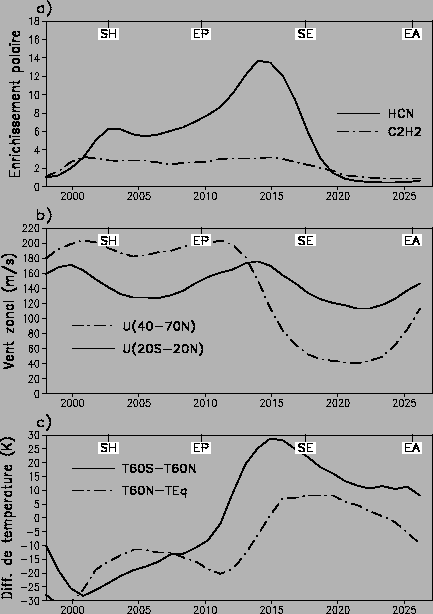

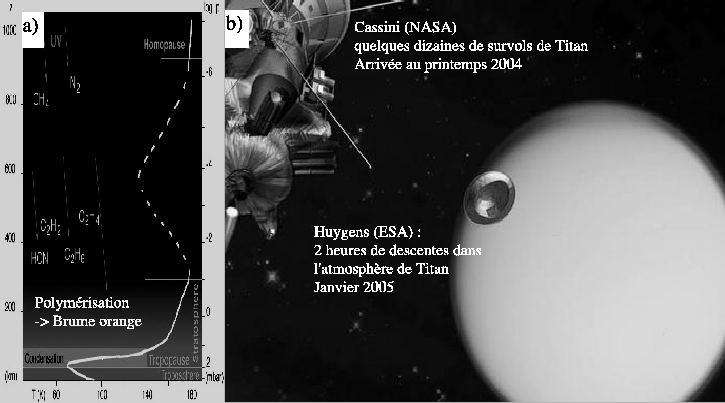

La dernière partie de ce document concerne Titan, le plus gros satellite de Saturne. Titan fait partie de ces objets fascinants du système solaire révélés par l'épopée Voyager. En 1981, les responsables des missions Voyager choisissent de privilégier pour la sonde Voyager 1 un survol de Titan plutôt que de poursuivre la course vers Uranus et Neptune (périple magistralement réussi ensuite par Voyager 2). On sait en effet à l'époque que Titan est, avec la Terre, le seul corps tellurique du système solaire entouré d'une atmosphère dense d'azote (1,5 bar à la surface). Les photos renvoyées vers la Terre sont très décevantes. Une épaisse couche de brume orangée voile entièrement la surface. Tout juste peut-on distinguer un léger contraste entre les deux hémisphères, signe probable d'un effet saisonnier. Les mesures spectroscopiques permettent en revanche d'identifier un grand nombre de composés chimiques, hydrocarbures et nitriles. Ces espèces chimiques, créées dans la très haute atmosphère à partir de la photo-dissociation de l'azote moléculaire et du méthane (second constituant atmosphérique) sont ensuite transportées vers le bas dans la stratosphère où on pense qu'elles polymérisent pour donner naissance à la brume orange. L'analyse des contrastes latitudinaux de température dans la stratosphère suggère également que l'atmosphère tourne beaucoup plus vite que le satellite, lui-même en phase bloquée autour de Saturne, avec une durée du jour de 16 jours terrestres environ. Si la direction de la rotation de l'atmosphère ne peut être obtenue à partir des observations de la température, l'analogie avec Vénus et des arguments théoriques suggèrent que l'atmosphère est en régime de ``superrotation", l'atmosphère vers 200 km tournant une dizaine de fois plus vite que la surface et dans la même direction.

Suite au passage des sondes Voyager, une mission est programmée vers le système de Titan, sous l'impulsion de Toby Owen et Daniel Gautier. La sonde américaine Cassini se consacrera au système de Saturne et emmènera à son bord la sonde européenne Huygens qui plongera dans l'atmosphère de Titan. Mission parfaitement remplie. Le 14 janvier 2005, après 7 années de voyage dans le système solaire, la sonde Huygens a dévoilé sous l'épaisse couche de brume des paysages familiers où chacun reconnaît qui sa Côte d'Azur, qui son lac de montagne ; en tout cas des images qui évoquent un rivage.

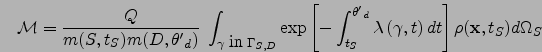

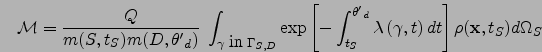

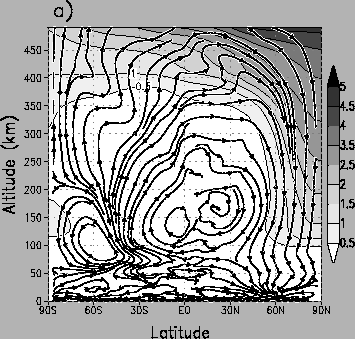

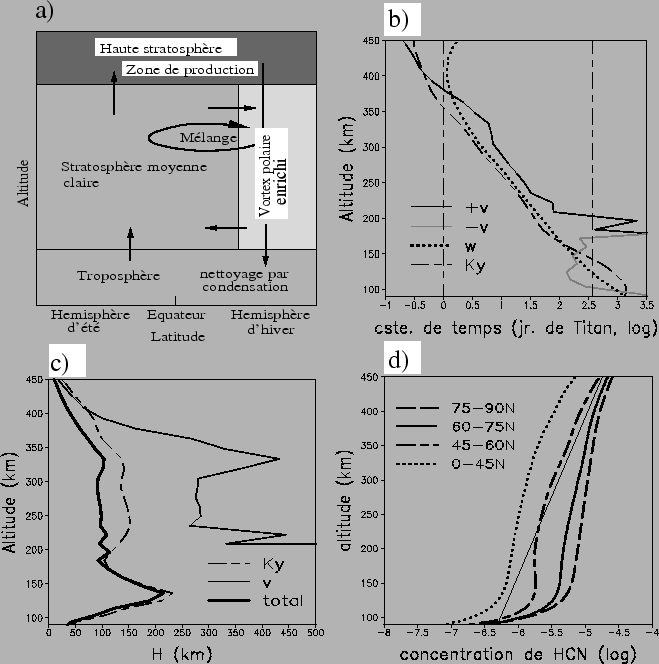

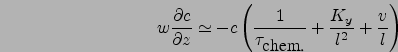

Au début des années 90s, sous l'impulsion de Daniel Gautier (LESIA) et Christopher P. McKay (NASA/Ames), différents travaux de modélisation sont entrepris pour interpréter les résultats des missions Voyager et préparer la mission Cassini-Huygens. Le modèle de circulation du LMD est adapté aux conditions de Titan (Hourdin et al., 1995b) et prédit effectivement une forte superrotation sur Titan, superrotation confirmée depuis par des mesures Doppler. En parallèle, des modèles unidimensionnels sont développés pour la photochimie (Toublanc et al., 1995) et la microphysique des brumes (Cabane et al., 1992; Rannou et al., 1995). Il apparaît cependant rapidement que les différentes composantes de ce système sont fortement couplées. Les brumes sont formées par la polymérisation des constituants chimiques et peuvent servir également de noyaux de condensation à ces dernières au niveau de la troposphère glaciale de Titan (70 K environ). Brumes et espèces chimiques sont évidemment transportées par les vents. En retour, les contrastes latitudinaux de la composition jouent les premiers rôles dans le forçage de la circulation. Vers 1995, nous décidons, avec Michel Cabane et Dominique Toublanc, de réunir les différents efforts de modélisation pour s'attaquer à ce système climatique complet.

En 1998, lors du colloque quadriénal du Programme National de Planétologie,

le programme est déjà clair

(Hourdin et al., 1998) :

``L'arrivée sur Titan de la mission Cassini-Huygens est sans doute une des dernières occasions

avant des décennies d'explorer un système physique analogue à la Terre mais encore très mal connu.

Pour l'atmosphère et le climat

en particulier, c'est une occasion unique avant longtemps de mettre à l'épreuve pour

une planète tellurique les théories

et modèles développés dans le contexte terrestre.

Cette perspective ainsi que la préparation de la mission (étude en amont et préparation de

l'analyse des résultats) ont motivé le développement d'un modèle de circulation générale de

l'atmosphère de Titan au Laboratoire de Météorologie Dynamique du CNRS, sous l'impulsion

de Daniel Gautier et en collaboration avec Christopher P. McKay (NASA/Ames) et Régis

Courtin (LESIA/Obs. Paris Meudon).

[...]

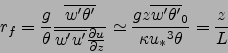

Pour Titan, le modèle prédit une stratosphère tournant environ 10 fois plus vite que la planète

solide avec des vents zonaux (d'ouest) de l'ordre de 100 m s![]() .

En plus de ce phénomène dynamique spectaculaire, les résultats du modèle ont contribué à mettre

en évidence l'importance des couplages entre dynamique atmosphérique, microphysique des

aérosols, et photochimie. Ceci nous a conduit à bâtir et à proposer au PNP pour les années

à venir, un projet de modélisation du climat de Titan intégrant ces différentes

composantes. L'enjeu est d'importance et la tâche ardue quand on connaît les problèmes

rencontrés dans la modélisation de ces problèmes sur Terre. Mais la perspective de la

confrontation du modèle aux observations de la mission Cassini-Huygens en 2005

en font [un objectif] scientifique de tout premier plan.''

.

En plus de ce phénomène dynamique spectaculaire, les résultats du modèle ont contribué à mettre

en évidence l'importance des couplages entre dynamique atmosphérique, microphysique des

aérosols, et photochimie. Ceci nous a conduit à bâtir et à proposer au PNP pour les années

à venir, un projet de modélisation du climat de Titan intégrant ces différentes

composantes. L'enjeu est d'importance et la tâche ardue quand on connaît les problèmes

rencontrés dans la modélisation de ces problèmes sur Terre. Mais la perspective de la

confrontation du modèle aux observations de la mission Cassini-Huygens en 2005

en font [un objectif] scientifique de tout premier plan.''

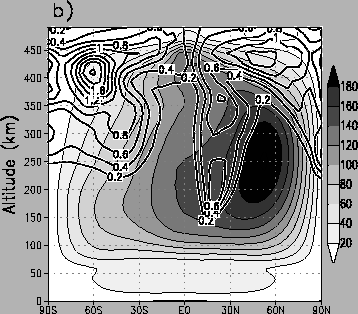

Après une mise en route souvent ardue, le modèle couplé a bien été développé. Il a permis de mettre en évidence le couplage très fort entre la brume et les vents (Rannou, 2004). Le modèle a également permis d'expliquer les contrastes latitudinaux observés dans la composition chimique (Hourdin, 2004; Lebonnois et al., 2001). Sur la base de simulations numériques effectuées avec cet outil, une base de données a été constituée et mise à disposition de la communauté sur la toile avant l'arrivée de la mission (Rannou et al., 2005). Les données sont là. Les premières photos ont réservé leur lot de surprises. Que nous réservent les dépouillements en cours des enregistrements des spectromètres et "imageurs spectraux" ou des mesures in-situ de la composition par Huygens ?

C'est cette histoire qui clôt ce document (Chapitre 5) avant quelques conclusions générales.

Le présent chapitre est consacré à la représentation du transport atmosphérique d'espèces traces dans les modèles de circulation atmosphérique de grande échelle ainsi qu'à la présentation d'un outil particulier : la version ``traceurs" du modèle de circulation générale LMDZ.

Le LMD développe et exploite depuis le début des années 70

un modèle de circulation générale atmosphérique.

Comme beaucoup d'autres, ce modèle s'est petit à petit enrichi pour devenir

un véritable

modèle climatique, avec par exemple la prise en compte des couverts végétaux

pour prédire le comportement thermodynamique des surfaces continentales ou

le couplage avec l'océan.

Le transport d'espèces traces est pour sa part introduit une première

fois par Sylvie Joussaume (1990) dans une version précédente du modèle de climat

du LMD pour étudier le cycle des poussières désertiques.

Christophe Genthon introduit ensuite le Radon (![]() Rn) et le

plomb (

Rn) et le

plomb (![]() Pb) dans le modèle en utilisant, pour représenter l'advection,

le schéma des Pentes du NASA/GISS (Preiss, 1997; Genthon, 1995).

Pb) dans le modèle en utilisant, pour représenter l'advection,

le schéma des Pentes du NASA/GISS (Preiss, 1997; Genthon, 1995).

Au milieu des années 80, Robert Sadourny et Phu LeVan entreprennent la réécriture du noyau hydrodynamique du modèle, afin de le rendre plus modulaire, lisible et efficace (l'ancien modèle avait été écrit sur cartes perforées par Phu LeVan pour des machines ne pouvant pas contenir un champ entier en mémoire) et de généraliser l'idée de grille étirable qui avait été une première fois testée pour étudier un cyclone en baie du Benghal. C'est cette possibilité de raffinement de la grille qui donnera plus tard le "Z" (pour zoom) de LMDZ. Du fait de l'inertie inhérente à la modélisation du climat terrestre (on regarde des choses très précises avec un modèle robuste dont on connaît bien le fonctionnement et dont on a ``réglé" la climatologie), ce nouveau noyau dynamique est dans un premier temps utilisé sur Mars (Hourdin et al., 1995a,1993) et Titan (Hourdin, 1992; Hourdin et al., 1995b). Pour ces deux planètes, un des prolongements possibles des études développées au LMD consistait à s'intéresser au cycle d'espèces transportées : les poussières sur Mars, avec les spectaculaires tempêtes globales qui peuvent voiler la surface de la planète pendant plusieurs dizaines de jours, et les brumes et espèces chimiques sur Titan, dont on montre dans le dernier chapitre de ce document qu'elles sont fortement couplées à la circulation atmosphérique.

Les traceurs sont introduits dans LMDZ en 1996, en utilisant, pour l'advection

de grande échelle, des schémas en volumes finis2.1.

Les schémas en volumes finis sont basés sur une partition du domaine considéré

en volumes de contrôle, aux frontières desquels on évalue les flux entrants

ou sortants de traceurs.

Ce sont des schémas basés sur une formulation intégrale de l'équation

de transport.

Nous avons plus précisément codé et testé une série de schémas en

volumes finis proposés à l'origine par Van Leer (1977).

Ces schémas conduisent facilement à une mise en ![]() uvre tridimensionnelle et

satisfont des propriétés physiques fondamentales du transport: localité,

conservation, monotonie, positivité (plus généralement pas de création

d'extrema numériques) et invariance par addition d'une constante au champ de

traceur.

Van Leer (1977) avait en fait proposé une hiérarchie de schémas dont les plus

sophistiqués ont été introduits ultérieurement et indépendamment dans la

communauté météorologique par Russell et Lerner (1981) (schéma des pentes du NASA/GISS) et

Prather (1986).

Avec Alexandre Armengaud alors en thèse au LGGE sous la direction de Christophe

Genthon, nous avons testé dans LMDZ plusieurs de ces schémas (Hourdin et Armengaud, 1999).

Nous avons pu montrer que leurs performances étaient

en fait assez semblables dès lors qu'on les comparait non pas à résolution

spatiale fixée mais à coût numérique équivalent (un schéma plus précis mais

plus coûteux se comporte comme un schéma moins précis mais utilisé sur une

grille plus fine). Nous avons retenu pour le modèle du LMD le schéma le plus

simple (le schéma I dans l'article original de Van Leer souvent appelé MUSCL

ou MINMOD).

uvre tridimensionnelle et

satisfont des propriétés physiques fondamentales du transport: localité,

conservation, monotonie, positivité (plus généralement pas de création

d'extrema numériques) et invariance par addition d'une constante au champ de

traceur.

Van Leer (1977) avait en fait proposé une hiérarchie de schémas dont les plus

sophistiqués ont été introduits ultérieurement et indépendamment dans la

communauté météorologique par Russell et Lerner (1981) (schéma des pentes du NASA/GISS) et

Prather (1986).

Avec Alexandre Armengaud alors en thèse au LGGE sous la direction de Christophe

Genthon, nous avons testé dans LMDZ plusieurs de ces schémas (Hourdin et Armengaud, 1999).

Nous avons pu montrer que leurs performances étaient

en fait assez semblables dès lors qu'on les comparait non pas à résolution

spatiale fixée mais à coût numérique équivalent (un schéma plus précis mais

plus coûteux se comporte comme un schéma moins précis mais utilisé sur une

grille plus fine). Nous avons retenu pour le modèle du LMD le schéma le plus

simple (le schéma I dans l'article original de Van Leer souvent appelé MUSCL

ou MINMOD).

Ce travail a donné naissance à la version traceurs du modèle, baptisée un moment LMDZT. En parallèle des schémas d'advection, il a fallu inclure, dans le modèle, le transport associé aux paramétrisations des mouvements non résolus, turbulents ou convectifs. Cette composante est souvent essentielle pour contrôler le transport vertical des espèces. Pour ces schémas, on suit généralement ce qui est fait pour transporter l'humidité ou la température potentielle dans les paramétrisations d'origine. L'introduction des traceurs dans les paramétrisations de la turbulence de couche limite et de la convection nuageuse a été initialement réalisée par Olivier Boucher et Alexandre Armengaud. Cette composante traceurs fait depuis partie intégrante du modèle LMDZ qui permet de transporter un nombre arbitraire de traceurs. De nombreuses applications ont été développées à partir de cette version, à la fois pour la Terre, Mars ou Titan, en lui adjoignant des modules de chimie ou de microphysique des aérosols.

LMDZT a été conçu de façon très modulaire de façon à pouvoir y rajouter facilement des codes de chimie ou des modules d'aérosols. Il est utilisable soit en mode ``branché'' (on-line en anglais), soit en mode débranché, en relisant des fichiers météorologiques issus d'une simulation numérique précédente. Les simulations météorologiques elles-mêmes peuvent être effectuées soit en mode climatique, en laissant le modèle évoluer librement à partir d'une condition initiale unique, soit en le ``guidant'' par des analyses météorologiques. Marie-Angèle Filiberti et Abderrahmane Idelkadi ont largement contribué à fiabiliser et valider l'ensemble des outils développés et présentés ici.

Ce chapitre relativement technique revient à la fois sur la présentation des schémas de transport et sur la description de LMDZT. Nous présentons à la fin quelques exemples de validations ou utilisations du modèle.

Avant d'introduire la composante traceurs, on présente rapidement le modèle LMDZ et notamment la discrétisation des équations de grande échelle sur laquelle s'appuie le transport des traceurs. On en profite pour donner un bref aperçu du contenu des paramétrisations physiques du modèle et des évolutions apportées récemment. 2.2

LMDZ correspond à la seconde génération d'un modèle de climat développé depuis une trentaine d'années au LMD et décrit initialement par Sadourny et Laval (1984). Ce modèle est plus modulaire et flexible2.3que son prédécesseur. Le ``Z" de son nom se réfère à la capacité de raffinement de la grille (Zoom) obtenue grâce à une écriture généralisée de la formulation numérique avec un maillage dont les facteurs d'élongation dans les deux directions horizontales peuvent être choisis arbitrairement.

Comme la plupart des modèles de climat, le modèle LMDZ intègre sur la sphère

et dans le temps les ``équations primitives de la météorologie".

Ces équations sont une version des équations de Navier Stokes simplifiées

en supposant que l'atmosphère est à tout moment en équilibre hydrostatique

sur la verticale et en négligeant les variations verticales de la géométrie

horizontale (hypothèse de couche mince).

Le moment cinétique par rapport à l'axe des pôles est

par exemple calculé en utilisant comme distance à l'axe

![]() - où

- où ![]() est le rayon de la planète

et

est le rayon de la planète

et ![]() la latitude - plutôt que

la latitude - plutôt que

![]() , qui tiendrait compte de

l'altitude

, qui tiendrait compte de

l'altitude ![]() d'une particule d'air au dessus de la surface.

d'une particule d'air au dessus de la surface.

Le modèle du LMD est bâti sur une discrétisation en différences finies de ces équations avec certaines propriétés intéressantes du schéma numérique comme la conservation de la masse, la conservation du moment cinétique par la composante axi-symétrique de l'écoulement et de la vorticité barotrope. On revient sur ces aspects en toute fin de chapitre.

Ces équations ne peuvent pas être intégrées jusqu'à l'échelle visqueuse. En pratique, dans les modèles globaux, on utilise des mailles de quelques dizaines à quelques centaines de kilomètres suivant les applications. L'impact des échelles sous-mailles sur la grande échelle doit donc être représenté au travers de paramétrisations. Il faut également représenter des processus fondamentaux comme le transfert de rayonnement visible et infrarouge dans l'atmosphère, les processus nuageux ou les interactions avec la surface. Dans le jargon des modélisateurs, ces paramétrisations sont regroupées dans la ``physique" du modèle, par opposition avec le code représentant la ``dynamique" de grande échelle. Dans le cas de l'utilisation du modèle de circulation pour d'autres planètes, c'est cette partie physique qui doit être largement modifiée, et notamment le calcul du transfert radiatif.

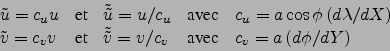

Dans le modèle LMDZ, les équations primitives sont discrétisées

horizontalement sur une grille-C dans la classification d'Arakawa

(cf. e. g. Kasahara, 1977).

On note ![]() et

et ![]() les coordonnées horizontales :

les coordonnées horizontales :

![]() (resp.

(resp. ![]() ) est une fonction biunivoque de la longitude

) est une fonction biunivoque de la longitude ![]() (resp. de la latitude

(resp. de la latitude ![]() ).

Les variables scalaires

(la température potentielle

).

Les variables scalaires

(la température potentielle ![]() , le géopotentiel

, le géopotentiel ![]() et la pression de surface

et la pression de surface ![]() ) sont évaluées aux points

correspondant à des couples de valeurs entières

) sont évaluées aux points

correspondant à des couples de valeurs entières ![]() .

Le vent zonal est calculé aux points

.

Le vent zonal est calculé aux points

![]() et le vent

méridien aux points

et le vent

méridien aux points

![]() .

La disposition des variables sur la grille est illustrée sur la

Fig. 2.1.

De façon à pouvoir modifier la distribution des longitudes et latitudes

de la grille, on utilise en fait les composantes covariantes

(

.

La disposition des variables sur la grille est illustrée sur la

Fig. 2.1.

De façon à pouvoir modifier la distribution des longitudes et latitudes

de la grille, on utilise en fait les composantes covariantes

(![]() et

et ![]() ) et contravariantes (

) et contravariantes (

![]() et

et

![]() )

du vent définies par

)

du vent définies par

|

(2.1) |

Comme beaucoup de modèles globaux, le modèle du LMD avait initialement

été codé avec une coordonnée verticale de type ![]() . La coordonnée

. La coordonnée

![]() (où

(où ![]() est la pression et

est la pression et ![]() la pression à la surface

au point considéré) est pratique parce qu'elle varie de 1 à la surface à 0

au sommet de l'atmosphère quelque soit le relief

sous-jacent. Cette coordonnée devient cependant problématique plus haut dans

l'atmosphère où on préfère travailler sur des isobares ou, mieux, sur

des isentropes.

Suivant là aussi beaucoup de modèles de climat, nous avons avec Phu LeVan

récrit le modèle en coordonnée hybride

la pression à la surface

au point considéré) est pratique parce qu'elle varie de 1 à la surface à 0

au sommet de l'atmosphère quelque soit le relief

sous-jacent. Cette coordonnée devient cependant problématique plus haut dans

l'atmosphère où on préfère travailler sur des isobares ou, mieux, sur

des isentropes.

Suivant là aussi beaucoup de modèles de climat, nous avons avec Phu LeVan

récrit le modèle en coordonnée hybride ![]() .

La coordonnée hybride est définie de façon implicite

comme donnant la pression dans la couche

.

La coordonnée hybride est définie de façon implicite

comme donnant la pression dans la couche ![]() du modèle sous la forme

du modèle sous la forme

Les niveaux de pression définis par la relation 2.2

correspondent aux interfaces entre les couches du modèle avec ![]() et

et ![]() ,

, ![]() étant le nombre de couches dans le modèle.

La masse d'air contenue dans une maille du modèle comprise entre les

niveaux

étant le nombre de couches dans le modèle.

La masse d'air contenue dans une maille du modèle comprise entre les

niveaux ![]() et

et ![]() est donnée par

est donnée par

| (2.3) |

| (2.4) |

On introduit alors les trois composantes du flux de masse :

| (2.5) |

On ne présente pas ici la discrétisation des équations du mouvements

qui n'a pas changé par rapport à la version ![]() du modèle

et dont ont discute en toute fin de chapitre.

En revanche, l'introduction de la coordonnée hybride à entraîné la

modification du schéma de calcul de la fonction d'Exner

du modèle

et dont ont discute en toute fin de chapitre.

En revanche, l'introduction de la coordonnée hybride à entraîné la

modification du schéma de calcul de la fonction d'Exner

![]() .2.5L'équilibre hydrostatique est intégré verticalement suivant le schéma :

.2.5L'équilibre hydrostatique est intégré verticalement suivant le schéma :

La première utilisation de ce nouveau code hydrodynamique est martienne. Le modèle du LMD est le premier à simuler un cycle saisonnier entier sur la planète rouge (Hourdin et al., 1993). Pendant ce temps le modèle climatique terrestre du LMD poursuit une vie trépidante. La version 4ter, qui donnait des résultats excellents sur la Mousson Indienne (présentez une simulation du modèle à un chercheur authentique du LMD, il commencera par regarder la ``précip'' de juillet sur l'Inde), est progressivement remplacée par les versions 5 et 6. Ces versions sont notamment couplées à SECHIBA pour la végétation et à ORCALIM pour l'océan.

C'est lors d'un séminaire interne du LMD, tenu en la royale abbaye de Fontevraud en 1990, qu'est prise collectivement la décision de faire de ce nouveau code dynamique l'ossature du futur modèle de climat du LMD. Ce choix est motivé par la volonté de disposer d'un outil souple et modulaire, permettant facilement l'échange et le test de modules et de procédures. Cette décision s'inscrit dans l'idée de modélisation communautaire alors dans l'air du temps.

Il faut donc adjoindre au code dynamique un jeu de paramétrisations physiques. Dans un premier temps, la décision est prise de partir de la physique du Centre Européen pour les Prévisions Météorologiques à Moyen Terme. Ce modèle contient en effet le code radiatif Fouquart/Morcrette, développé à l'origine pour le modèle du LMD, et les schémas de nuages d'Hervé LeTreut. Cette décision ne sera finalement pas tenue. Si Laurent Li s'est bien battu pour effectuer les portages nécessaires, le groupe décidera quelques années plus tard de privilégier la continuité avec les versions précédentes.2.7C'est la combinaison de ce nouveau code dynamique et de la réécriture des paramétrisations physiques qui donnera naissance au modèle LMDZ d'aujourd'hui.

On décrit ci-dessous dans ses grandes lignes la version du modèle LMDZ3.3 qui a été utilisée pour les applications "traceurs" décrites dans ce document ainsi que les évolutions apportées au court de la mise au point du modèle couplé IPSLCM4 et qui définissent la version LMDZ4 (Hourdin et al., 2006).

L'effet de la turbulence de petite échelle dans la couche limite est pris en compte au moyen d'une fermeture en super-viscosité avec un flux turbulent proportionnel au gradient vertical de la quantité transportée. La viscosité turbulente dépend du cisaillement vertical du vent et du nombre de Richardson, selon les formules présentées par Laval et al. (1981). Un "contre-gradient" est introduit sur la température potentielle pour permettre un transport de chaleur "en remontant le gradient" dans les couches limites marginalement stables. On revient très largement sur ces aspects relatifs à la couche limite dans le Chapitre 3.

Le code radiatif est celui du modèle du Centre Européen pour les Prévisions Météorologiques à Moyen Terme (Morcrette, 1991). La partie concernant l'absorption et la diffusion du rayonnement solaire est une version raffinée du modèle de Fouquart et Bonnel (1980). La partie infrarouge thermique a été développée par Morcrette et al. (1986). La condensation est paramétrée de façon différente pour la convection profonde et pour les autres nuages. Pour la convection nuageuse, on utilise la paramétrisation développée par Tiedtke (1989). Cette paramétrisation est basée sur une représentation en flux de masse d'une colonne convective nuageuse idéalisée. La colonne atmosphérique est divisée en trois sous-colonnes : une ascendance concentrée, une subsidence rapide associée à la pluie et enfin l'environnement, généralement en subsidence lente. Pour la partie non convective des nuages, on diagnostique une fraction nuageuse et un contenu en eau des nuages en se donnant a priori une fonction de distribution sous-maille de l'eau (Le Treut et Li, 1991). Les nuages ainsi diagnostiqués sont utilisés à la fois pour le calcul radiatif et pour calculer un taux de chauffage et un taux de précipitation. La pluie calculée ainsi peut se réévaporer dans les couches inférieures du modèle. L'eau vapeur et l'eau condensée sont ensuite advectées indépendamment dans la partie dynamique2.8. Le transport de grande échelle de la vapeur d'eau et de l'eau liquide, traité à l'origine avec un schéma amont très diffusif sur l'horizontale et un schéma centré non positif sur la verticale, est maintenant calculé avec les schémas en volumes finis décrits un peu plus loin.

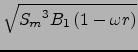

Dans les expériences présentées dans ce document, la température de surface

de la mer est imposée. La conduction thermique dans les sols

continentaux est quant à elle calculée au moyen d'un schéma multi-couches

d'un sol homogène

développé à l'origine pour la version martienne du modèle

(Hourdin et al., 1993).

Si on note ![]() la conduction thermique du sol et

la conduction thermique du sol et ![]() la capacité thermique

volumique, on peut montrer facilement que le flux conductif à la surface

peut s'écrire sous la forme

la capacité thermique

volumique, on peut montrer facilement que le flux conductif à la surface

peut s'écrire sous la forme

![]() et la conduction dans le sol

et la conduction dans le sol

![]() .

.

![]() est appelé inertie thermique et

est appelé inertie thermique et ![]() est une pseudo profondeur

définie par

est une pseudo profondeur

définie par

![]() .

.

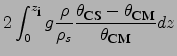

Suivant Laval et al. (1981), l'évaporation à la surface est calculée comme

![]() où

où ![]() est la tension de vent en surface,

est la tension de vent en surface,

![]() est l'humidité spécifique de la première couche du modèle atmosphérique

et

est l'humidité spécifique de la première couche du modèle atmosphérique

et ![]() est l'humidité spécifique à saturation pour la température de

surface

est l'humidité spécifique à saturation pour la température de

surface ![]() .

Le coefficient d'aridité

.

Le coefficient d'aridité ![]() peut être soit imposé soit dépendre directement

d'un contenu en eau du sol, calculé au fil du temps en fonction du bilan

entre précipitation et évaporation,

peut être soit imposé soit dépendre directement

d'un contenu en eau du sol, calculé au fil du temps en fonction du bilan

entre précipitation et évaporation,

![]() .

Le modèle utilisé par défaut, dit modèle du saut d'eau (bucket en anglais),

fait l'hypothèse que

.

Le modèle utilisé par défaut, dit modèle du saut d'eau (bucket en anglais),

fait l'hypothèse que ![]() peut

croître jusqu'à une valeur de 150 mm d'eau. Entre 75 et 150 mm, le coefficient

d'aridité

peut

croître jusqu'à une valeur de 150 mm d'eau. Entre 75 et 150 mm, le coefficient

d'aridité ![]() est égal à 1 et l'évaporation est égale à l'évaporation

potentielle. Ce coefficient varie linéairement entre 0 et 1 pour des contenus

en eau du sol variant de 0 à 75 mm.

est égal à 1 et l'évaporation est égale à l'évaporation

potentielle. Ce coefficient varie linéairement entre 0 et 1 pour des contenus

en eau du sol variant de 0 à 75 mm.

La partie physique du modèle est en fait en évolution constante. La description qui en est faite ci-dessus correspond à une vue instantanée de la version qui a servi à développer les aspects liés au transport des traceurs. Sauf mention explicite, c'est cette version de LMDZ3 qui est utilisée dans les simulations présentées dans ce document.

|

|

Depuis, notamment en vue du développement du modèle couplé IPSLCM4, la physique du modèle a évolué de façon significative. Les améliorations principales concernent :

On ne s'appesantit pas dans ce document sur la climatologie du modèle d'atmosphère. On montre cependant une comparaison de la version précédente LMDZ3 du modèle et du nouveau modèle LMDZ4 en ce qui concerne la précipitation (Fig. 2.2 et Fig. 2.3). Les différences principales entre les deux versions proviennent en fait du changement de schéma de convection. L'ancien modèle avait tendance à exagérer l'intensité des précipitations tropicales dans les zones de convergences, notamment à l'Est de Madagascar ainsi que sur l'océan Pacifique. Ce biais est nettement diminué dans le nouveau modèle. La diminution (amélioration) des précipitations sur les continents nord en été (Sibérie, Canada), est elle davantage due au schéma de surface. La détérioration la plus notable avec le nouveau modèle est sans doute la distribution des précipitations de mousson autour de l'Inde en juillet. Lorsqu'on interprète des résultats relatifs à la simulation des concentrations atmosphériques d'aérosols ou d'espèces chimiques, il faut bien sûr garder à l'esprit ces différences quant à la capacité du modèle à simuler correctement le climat.

L'organisation du modèle LMDZ est très étroitement calquée sur cette distinction entre partie "dynamique" - la seule partie où soient pris en compte des échanges horizontaux entre des mailles du modèle - et la partie ``physique" qui peut être vue comme une juxtaposition de ``colonnes" d'atmosphère.

Cette spécificité de la partie physique est exploitée en ce sens que le codage de toutes les paramétrisations est fait avec un indice interne muet qui représente la grille horizontale. Cette organisation est illustrée sur la Fig. 2.4. Chacune des parties, physique et dynamique, a ses propres fichiers de conditions initiales et de sorties.

Cette écriture se prête à la fois à la vectorisation et à la parallélisation des codes. Cette approche permet également de disposer de façon transparente d'une version unidimensionnelle du modèle de circulation. Pour disposer d'un modèle unidimensionnel, il suffit d'écrire un programme dans lequel on initialise des profils météorologiques sur un point particulier du globe et dans lequel on appelle ensuite en boucle le moniteur physique.

Autre atout important, cette conception modulaire permet de gérer en parallèle des ``physiques" différentes interfacées avec le même code dynamique. Ce point est essentiel pour les études menées au LMD sur Mars et sur Titan. Enfin, on peut noter qu'il existe aussi une version bidimensionnelle, latitude-altitude, du noyau dynamique du modèle qui a été abondamment utilisée sur Titan comme on le voit à la fin de ce document.

Le modèle LMDZ est avant tout développé pour des études climatiques.

On effectue alors des intégrations longues, dans lesquelles l'état

initial est vite ``oublié" et les résultats ne s'interprètent qu'en termes

statistiques.

Cependant, notamment pour des aspects de validation, il peut s'avérer

utile de contraindre le modèle à suivre une situation météorologique

observée.

Dans ce mode ``guidé" (on parle souvent de ``nudging" en anglais), les

champs du modèle sont rappelés avec un terme linéaire vers les champs

des analyses ou des réanalyses

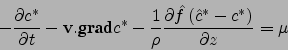

| (2.22) |

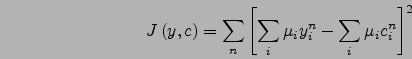

Une approche intermédiaire a été mise en ![]() uvre dans LMDZ

(Bonazzola, 2001).

Elle consiste à minimiser

une fonction mesurant la distance entre l'état du modèle et les analyses.

Cette approche, qui s'apparente encore davantage à l'assimilation

météorologique opérationnelle,

permet d'introduire, en plus des analyses, des observations

supplémentaires ou des contraintes comme des pénalités sur les modes

de gravité excités par la procédure d'assimilation.

Cette dernière méthode n'est pas utilisée ici.

uvre dans LMDZ

(Bonazzola, 2001).

Elle consiste à minimiser

une fonction mesurant la distance entre l'état du modèle et les analyses.

Cette approche, qui s'apparente encore davantage à l'assimilation

météorologique opérationnelle,

permet d'introduire, en plus des analyses, des observations

supplémentaires ou des contraintes comme des pénalités sur les modes

de gravité excités par la procédure d'assimilation.

Cette dernière méthode n'est pas utilisée ici.

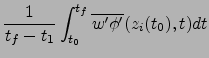

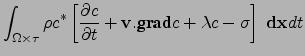

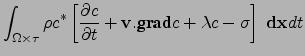

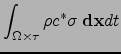

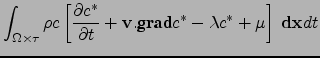

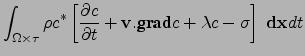

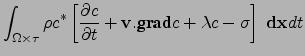

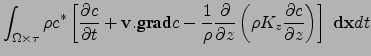

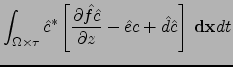

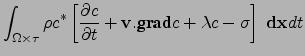

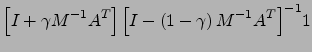

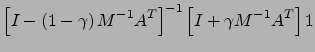

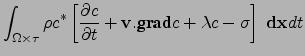

Dans les modèles de chimie-climat comme dans les modèles débranchés transport-chimie, les processus comme la microphysique des aérosols ou les réactions chimiques d'une part et le transport de l'autre sont généralement traités alternativement et séquentiellement. On parle en anglais d'``operator splitting". La partie transport proprement dite peut alors être traitée de façon systématique, indépendamment de l'espèce trace considérée, en assimilant cette espèce à un traceur conservé2.9.

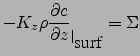

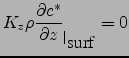

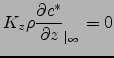

Dans cette partie, on

s'intéresse donc à la modélisation du

transport d'un traceur conservatif (une espèce trace suivant exactement

l'air) et passif (n'affectant pas en retour la météorologie).

L'équation du transport pour un traceur de ce type est simplement

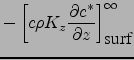

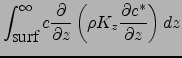

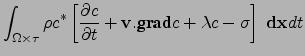

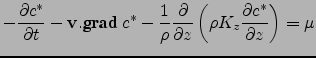

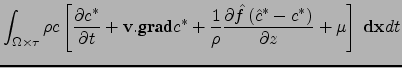

| (2.23) |

| (2.24) |

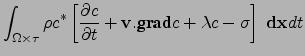

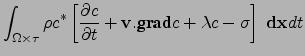

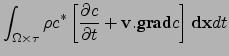

Dans les applications atmosphériques classiques, l'équation du transport ne peut être résolue jusqu'à l'échelle de la diffusion moléculaire. Cette constatation s'applique d'ailleurs aussi bien à l'observation qu'à la modélisation. Dans les deux cas, on travaille explicitement jusqu'à une échelle donnée mais on traite la petite échelle de façon statistique. Dans le cas d'un modèle numérique, la grande échelle est définie en pratique par le maillage (ou par la troncature pour les modèles spectraux). L'effet des grandeurs sous-mailles sur les variables de grande échelle ne peut être représenté que de façon statistique, au travers de paramétrisations.

Pour séparer échelle explicite et échelle turbulente, on introduit

la notion de moyenne d'ensemble.

La turbulence est considérée comme un processus

aléatoire. Un élément du processus correspond à une réalisation complète

de l'écoulement atmosphérique.

La moyenne d'ensemble d'une grandeur ![]() , qu'on notera

, qu'on notera ![]() ,

est simplement l'espérance mathématique de cette variable.2.10

,

est simplement l'espérance mathématique de cette variable.2.10

Pour introduire proprement le découpage pour un fluide compressible,

il faut introduire en plus une moyenne

pondérée par l'air

![]() .

La fluctuation turbulente par rapport à cette moyenne

.

La fluctuation turbulente par rapport à cette moyenne

![]() obéit à l'identité

obéit à l'identité

![]() .

.

Si on note ![]() le champ de vent et

le champ de vent et ![]() la concentration massique d'un

traceur conservatif (

la concentration massique d'un

traceur conservatif (![]() ),

l'équation de transport non visqueux peut s'écrire soit

),

l'équation de transport non visqueux peut s'écrire soit

En prenant la moyenne d'ensemble de la forme conservative et en remarquant

que

| (2.28) |

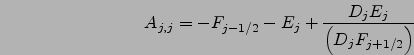

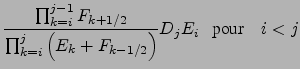

Ci-dessous, on présente en détail les schémas introduits pour traiter du transport de grande échelle ainsi que les paramétrisations des termes turbulents calquées sur les paramétrisations d'origine du code LMDZ. Dans le chapitre suivant, on présente en détail un travail spécifique mené sur le transport turbulent dans la couche limite convective.

De nombreuses méthodes ont été développées au cours des dernières décennies pour représenter l'advection, c'est à dire les parties non turbulentes des Eqs 2.30 ou 2.29 formellement équivalentes aux Eqs 2.25 et 2.27.

On distingue notamment :

Les formulations en ``volumes finis" présentent l'avantage très important d'être conservatives par nature, dès lors que le même flux est utilisé pour les volumes en amont et en aval de l'interface considérée.

Pour le plus connu de ces schémas, introduit par Godunov (1959),

![]() est simplement estimé comme le produit de

est simplement estimé comme le produit de ![]() par la valeur de

par la valeur de

![]() dans le volume amont (dans la maille d'où l'air provient).

Ce schéma simple, souvent appelé schéma amont,

garantit

dans le volume amont (dans la maille d'où l'air provient).

Ce schéma simple, souvent appelé schéma amont,

garantit

Van Leer (1977) a proposé d'utiliser, pour la valeur amont de ![]() , non pas

la valeur moyenne dans la maille amont mais une valeur extrapolée

à la frontière de celle-ci, en utilisant une approximation

polynomiale de la distribution sous-maille du traceur dans la maille

amont.

Deux des schémas proposés par Van Leer en 1977 ont été introduits

apparemment indépendamment dans la littérature météorologique par

Russell et Lerner (1981) - le schéma III dans la classification de Van Leer -

et Prather (1986) - le schéma VI -.

Alors que dans son article original, Van Leer conclut que la complexité

du schéma VI est trop grande par rapport au gain en précision, ce schéma

est devenu une référence dans la communauté météorologique.

, non pas

la valeur moyenne dans la maille amont mais une valeur extrapolée

à la frontière de celle-ci, en utilisant une approximation

polynomiale de la distribution sous-maille du traceur dans la maille

amont.

Deux des schémas proposés par Van Leer en 1977 ont été introduits

apparemment indépendamment dans la littérature météorologique par

Russell et Lerner (1981) - le schéma III dans la classification de Van Leer -

et Prather (1986) - le schéma VI -.

Alors que dans son article original, Van Leer conclut que la complexité

du schéma VI est trop grande par rapport au gain en précision, ce schéma

est devenu une référence dans la communauté météorologique.

Les principes de dérivation de ces différents schémas sont exposés ci-dessous.

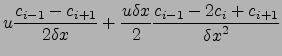

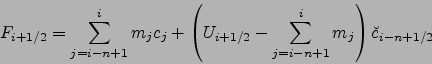

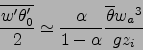

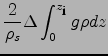

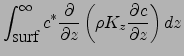

En dimension 1 et après intégration sur un pas de temps, les

Eq. 2.31 et 2.32 s'écrivent simplement

Si on connaît complètement la distribution spatio-temporelle du vent, de la

densité de l'air et de la concentration de traceur, on a

| (2.35) |

| (2.36) |

| (2.37) |

| (2.38) |

Dans la présentation faite ici, on considère que les transferts

de masse ![]() sont connus à chaque instant et sur tout le maillage.

L'évolution temporelle de la masse d'air

sont connus à chaque instant et sur tout le maillage.

L'évolution temporelle de la masse d'air

![]() est donc également complètement déterminée.

La seule chose qui reste à estimer est le flux de traceur.

est donc également complètement déterminée.

La seule chose qui reste à estimer est le flux de traceur.

De façon générale, ce flux ![]() peut être écrit comme le produit

du transfert de masse

peut être écrit comme le produit

du transfert de masse ![]() par la valeur moyenne de la concentration

du traceur

par la valeur moyenne de la concentration

du traceur

![]() dans l'air qui traverse l'interface au cours du pas

de temps.

dans l'air qui traverse l'interface au cours du pas

de temps.

![\includegraphics[width=16cm]{lmdzt/FIGURES/schema2.eps}](img222.png) |

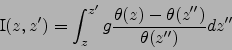

La méthode proposée par Van Leer consiste à approximer la distribution

sous-maille par un polynôme pour lequel le calcul de

![]() - et

donc du transfert de traceur - peut être fait exactement.

Le principe et les notations sont illustrées sur la Fig. 2.5

pour le cas d'un polynôme du premier degré.

Avec ces notations, les valeurs moyennes de

- et

donc du transfert de traceur - peut être fait exactement.

Le principe et les notations sont illustrées sur la Fig. 2.5

pour le cas d'un polynôme du premier degré.

Avec ces notations, les valeurs moyennes de ![]() et

et ![]() après un pas de temps

d'advection s'écrivent simplement

après un pas de temps

d'advection s'écrivent simplement

Pour des valeurs positives de ![]() et

et ![]() ,

l'Eq. 2.39 peut se récrire

,

l'Eq. 2.39 peut se récrire

Un des points essentiels de l'article original de Van Leer (1977) est

de remarquer qu'on peut garantir la monotonie du schéma d'advection

- en dimension 1, une distribution monotone reste monotone après advection -

en imposant que ![]() prenne une valeur intermédiaire entre les

deux valeurs voisines de

prenne une valeur intermédiaire entre les

deux valeurs voisines de ![]() dans les régions où

dans les régions où ![]() est monotone.

est monotone.

Supposons pour fixer les idées que

![]() et

et ![]() .

La condition ci-dessus s'écrit simplement

.

La condition ci-dessus s'écrit simplement

Si on rajoute en plus la condition que

![]() (distribution sous-maille constante)

quand

(distribution sous-maille constante)

quand ![]() est un extremum, on interdit la croissance des extrema.

Ceci implique de fait la positivité du schéma et interdit la création

d'oscillations provenant du caractère dispersif du schéma numérique

(provenant de l'advection avec des vitesses différentes des

différentes composantes de fourier de la distribution, cf. e. g. Rood, 1987).

est un extremum, on interdit la croissance des extrema.

Ceci implique de fait la positivité du schéma et interdit la création

d'oscillations provenant du caractère dispersif du schéma numérique

(provenant de l'advection avec des vitesses différentes des

différentes composantes de fourier de la distribution, cf. e. g. Rood, 1987).

Noter aussi qu'avec les définitions ci-dessus, une distribution uniforme

de traceur sera inchangée par l'advection, même avec des champs de vents

divergents (on s'en convainc en remplaçant

![]() et

et

![]() par une valeur constante dans l'Eq. 2.39).

par une valeur constante dans l'Eq. 2.39).

Dans les dérivations ci-dessus, on a supposé implicitement que le pas

de temps était suffisamment petit pour éviter de transférer plus que la

maille d'une cellule en un pas de temps (nombre de Courant ![]() inférieur

à 1). Si le flux de masse est exactement égal à la masse d'air dans le

volume amont, on calculera la distribution de traceur exactement, quelque

soit l'approximation choisie pour la distribution sous-maille.

inférieur

à 1). Si le flux de masse est exactement égal à la masse d'air dans le

volume amont, on calculera la distribution de traceur exactement, quelque

soit l'approximation choisie pour la distribution sous-maille.

La première approximation consiste à supposer que le traceur est constant

dans chaque maille (polynôme de degré zéro).

![]() est alors simplement la valeur de

est alors simplement la valeur de ![]() dans la maille amont

(

dans la maille amont

(

![]() si

si ![]() et

et ![]() sinon).

Ce schéma proposé à l'origine par Godunov (1959) est bon marché, positif

et monotone mais au prix d'une diffusion numérique très forte.

La diffusivité du schéma peut d'ailleurs être quantifiée.

Dans le cas d'un champ de vent non divergent

(

sinon).

Ce schéma proposé à l'origine par Godunov (1959) est bon marché, positif

et monotone mais au prix d'une diffusion numérique très forte.

La diffusivité du schéma peut d'ailleurs être quantifiée.

Dans le cas d'un champ de vent non divergent

(

![]() cste à une dimension),

le schéma 2.39 s'écrit

cste à une dimension),

le schéma 2.39 s'écrit

| (2.44) |

|

|

(2.45) | |

|

(2.46) |

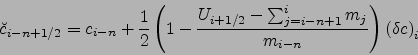

Pour passer à un ordre supérieur, on

suppose que la distribution sous-maille est linéaire avec une pente

![]() donnant les valeurs aux bords gauche et droit de la maille

donnant les valeurs aux bords gauche et droit de la maille ![]() comme

comme

![]() (voir l'illustration de la Fig. 2.5).

(voir l'illustration de la Fig. 2.5).

Dans ce cas,

![]() est donné par

est donné par

|

(2.47) | ||

|

(2.48) |

Différents schémas ont été proposés (Van Leer, 1977,1979)

correspondant à différentes estimations de

![]() , dont deux schémas

particulièrement intéressants, l'un pour son faible coût et l'autre pour

sa précision.

, dont deux schémas

particulièrement intéressants, l'un pour son faible coût et l'autre pour

sa précision.

![\includegraphics[width=9.cm]{lmdzt/FIGURES/schema3.eps}](img259.png)

![\includegraphics[width=7.cm]{lmdzt/FIGURES/1dn.eps}](img260.png) |

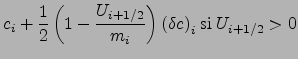

Dans le schéma I de Van Leer, la pente est simplement estimée à chaque pas

de temps par différences finies

(

![]() ) comme l'illustre

le graphique a de la Fig. 2.6.

Ce schéma peut être considéré comme une version volumes-finis du schéma de

From (1968).

) comme l'illustre

le graphique a de la Fig. 2.6.

Ce schéma peut être considéré comme une version volumes-finis du schéma de

From (1968).

Dans le second schéma, la pente au pas de temps ![]() dans une maille

donnée est calculée à partir de la distribution en ligne brisée résultant de

l'advection au temps

dans une maille

donnée est calculée à partir de la distribution en ligne brisée résultant de

l'advection au temps ![]() (illustration sur le graphique b de la Fig. 2.6).

La nouvelle distribution sous-maille

minimise la distance quadratique par rapport à cette distribution.

Ce second schéma (le schéma III dans l'article original de Van Leer)

a en fait été redécouvert quelques années plus tard par

Russell et Lerner (1981)2.13

dans un contexte météorologique tridimensionnel.

Ce schéma a été popularisé dans le modèle de circulation générale

du NASA/GISS. On l'appelle souvent

schéma des pentes (``slopes scheme" en anglais). On retiendra ce nom dans ce

qui suit.

(illustration sur le graphique b de la Fig. 2.6).

La nouvelle distribution sous-maille

minimise la distance quadratique par rapport à cette distribution.

Ce second schéma (le schéma III dans l'article original de Van Leer)

a en fait été redécouvert quelques années plus tard par

Russell et Lerner (1981)2.13

dans un contexte météorologique tridimensionnel.

Ce schéma a été popularisé dans le modèle de circulation générale

du NASA/GISS. On l'appelle souvent

schéma des pentes (``slopes scheme" en anglais). On retiendra ce nom dans ce

qui suit.

On présente, sur le graphique c de la Fig. 2.6, un exemple typique de calcul d'advection unidimensionnel avec le schéma de Godunov, Van Leer I et le schéma des pentes. Le schéma des pentes est bien sûr le plus précis mais la différence principale se situe entre le schéma de Godunov, extrêmement diffusif, et les deux autres. On voit également apparaître pour les deux schémas d'ordre 2 des oscillations provenant de la non monotonie du schéma et la création de valeurs négatives.

L'un des intérêts principaux du travail de Van Leer (1977) réside dans la possibilité qu'il offre d'assurer facilement la monotonie des schémas. Une première façon consiste à appliquer directement la contrainte explicitée à la fin de la Section 2.3.3.

Pour les schémas du second ordre,

Van Leer (1977) propose aussi une condition suffisante à la fois plus

brutale et plus simple. Il suffit, pour que le schéma soit monotone, d'imposer

que la distribution dans une maille ![]() soit entièrement comprise entre

les valeurs moyennes des deux mailles adjacentes et que la pente soit

du même signe que dans ces deux mailles (à noter que ce dernier critère

est automatiquement satisfait par le schéma I).

Cette condition suffisante peut s'exprimer facilement comme un

limiteur de pente.

Pour le schéma I, la formulation complète du calcul de la pente avec limiteur

s'écrit simplement

soit entièrement comprise entre

les valeurs moyennes des deux mailles adjacentes et que la pente soit

du même signe que dans ces deux mailles (à noter que ce dernier critère

est automatiquement satisfait par le schéma I).

Cette condition suffisante peut s'exprimer facilement comme un

limiteur de pente.

Pour le schéma I, la formulation complète du calcul de la pente avec limiteur

s'écrit simplement

![\includegraphics[width=15.cm]{lmdzt/FIGURES/schema4b.eps}](img265.png) |

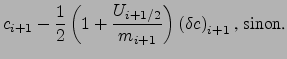

L'effet de l'application d'un limiteur fort (décrit ici) ou d'un limiteur faible (application directe des Eq. 2.42 et Eq. 2.43), qui correspondent respectivement aux Eq. (66) et (74) données par Van Leer (1977) est illustré sur la Fig. 2.7a. Un test numérique de l'impact de ces limiteurs est montré sur les Fig. 2.7c et d. Le limiteur fort dégrade de façon significative la précision du schéma des pentes tandis que le limiteur faible corrige ce schéma de façon sélective au niveau des oscillations, sans émousser par exemple le sommet de la gaussienne. Pour le schéma I, la différence entre les deux limiteurs est nettement plus marginale.

Il existe une alternative élégante à l'Eq. 2.49 qui consiste à

utiliser la moyenne géométrique des deux pentes voisines

La description de la distribution sous-maille du traceur peut être encore améliorée en utilisant un polynôme du second ordre. L'équivalent du schéma I de Van Leer (le schéma IV dans l'article original) consiste à évaluer les coefficients de ce polynôme par différences finies à partir des valeurs moyennes dans les mailles. Van Leer a attaché peu d'importance à ce schéma qui présente par exemple comme défaut de n'être pas plus précis que le schéma I pour un nombre de Courant de 0,5. Cependant, pour des valeurs plus petites, il peut devenir nettement plus précis. Comme le schéma I, ce schéma présente l'intérêt de n'utiliser qu'un traceur par point de grille. Woodward et Colella (1981) ont développé une alternative au schéma IV en utilisant un filtre non-linéaire assez élaboré permettant de renforcer les pentes en cas de choc (se reporter également à Woodward et Colella, 1984; Colella et Woodward, 1984). La méthode qui en résulte a été baptisée Piecewise Parabolic Method. Elle a été utilisée pour les applications atmosphériques par exemple par Carpenter et al. (1990), Lin et Rood (1996) ou Vautard et al. (2001). Dans ce manuscrit on ne présente pas les résultats avec PPM. Mais des tests ont été réalisés récemment avec ce schéma qui se comporte de façon assez similaire au schéma des pentes pour un coût numérique intermédiaire entre les schémas I et III (pentes) en termes de temps de calcul. Le coût en stockage est le même que pour le schéma I.

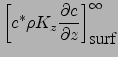

L'équivalent à l'ordre 3 du schéma III de Van Leer est le schéma VI

connu dans la littérature météorologique sous le nom de schéma

de Prather (1986).

Le schéma de Prather est évidemment beaucoup plus précis que tous les

schémas présentés jusque là comme le montrent les illustrations de la

section suivante.

Cependant, il nécessite la conservation de 10 traceurs indépendants :

la moyenne, les 3 pentes dans les 3 directions d'espace ![]() ,

, ![]() ,

,

![]() et les 6 moments du second ordre

et les 6 moments du second ordre ![]() ,

, ![]() ,

, ![]() ,

,

![]() ,

, ![]() et

et ![]() .

Il est également nécessaire de lui adjoindre des algorithmes du type limiteurs

de pente pour éviter complètement les oscillations numériques ou les valeurs

négatives.

.

Il est également nécessaire de lui adjoindre des algorithmes du type limiteurs

de pente pour éviter complètement les oscillations numériques ou les valeurs

négatives.

L'introduction des schémas en volumes finis est relativement facile dans le modèle de circulation générale LMDZ car les flux de masse sont déjà définis sur une grille décalée. Ces flux de masse sont ceux utilisés dans la partie météorologique pour intégrer l'équation de continuité pour l'air, à savoir l'Eq. 2.33 ou l'Eq. 2.88 donnée plus loin.

![\includegraphics[height=8cm]{lmdzt/FIGURES/schemsplit.eps}](img277.png)

![\includegraphics[height=9cm]{lmdzt/FIGURES/split.eps}](img278.png) |

Les présentations ci-dessus ont été faites avec une seule dimension d'espace. Une solution naturelle pour passer en 3 dimensions consiste à calculer d'abord les flux dans chaque dimension puis à calculer la divergence des flux.

Une alternative classique consiste à faire trois calculs d'advection, successivement dans les trois directions. On parlera de flux alternés ou de directions alternées.

Cette seconde méthode est curieusement plus précise dans le cas d'une advection

en diagonale par rapport au maillage.

Ceci est illustré sur la Fig. 2.8 pour une configuration bidimensionnelle.

Si on considère un pas de temps d'advection, le calcul direct ne tient

pas compte de l'air passant directement dans la maille située en

diagonale par rapport à la maille du milieu (le petit carré sombre

sur les figures). En revanche, cet air est compté deux fois, une fois dans

l'advection en ![]() et une fois dans l'advection en

et une fois dans l'advection en ![]() .

Ceci produit une très forte diffusion latéral en réduisant la propagation

dans la direction du mouvement. En partant d'un panache gaussien, la

distribution obtenue s'étire dans la direction transverse à l'écoulement

(en haut à droite sur la figure).

.

Ceci produit une très forte diffusion latéral en réduisant la propagation

dans la direction du mouvement. En partant d'un panache gaussien, la

distribution obtenue s'étire dans la direction transverse à l'écoulement

(en haut à droite sur la figure).

Au contraire, pour l'advection en flux alternés, le carré sombre commence par passer dans la maille située à droite de la maille d'origine puis en haut et arrive bien finalement dans la maille située en diagonale par rapport à la maille d'origine. Si on pouvait à chaque instant connaître exactement la distribution sous-maille du traceur, on aurait donc un calcul exact.

Dans la méthode des flux alternés, on intègre successivement non seulement l'équation d'advection du traceur (Eq. 2.39) mais aussi l'advection de transport de l'air (Eq. 2.40)2.14. Avec cette approche, une distribution uniforme de traceur est inchangée par l'advection indépendamment du caractère divergent ou non du champ de vent (Lin et Rood, 1996, montrent que ce n'est pas garanti par toutes les formulations en flux alternés).

Cette approche en flux alternés est utilisée assez systématiquement dans les calculs d'advection en volumes finis (Van Leer, 1979; Prather, 1986; Allen et al., 1991; Russell et Lerner, 1981).

On utilise ici la séquence proposée par Russell et Lerner (1981) :

| Direction | pas de temps |

| X | |

| Y | |

| Z | |

| Y | |

| X |

Si on veut ne travailler qu'avec des nombres de Courant

(

![]() ou

ou ![]() ) inférieurs à 1,

le raffinement de la discrétisation près des pôles, inhérent aux

grilles globales longitudes-latitudes, nécessite l'utilisation de pas de temps

extrêmement petits dans la direction longitudinale.

Une possibilité pour résoudre ce problème consiste à découper encore

davantage le pas de temps pour l'advection longitudinale.

) inférieurs à 1,

le raffinement de la discrétisation près des pôles, inhérent aux

grilles globales longitudes-latitudes, nécessite l'utilisation de pas de temps

extrêmement petits dans la direction longitudinale.

Une possibilité pour résoudre ce problème consiste à découper encore

davantage le pas de temps pour l'advection longitudinale.

Il existe une alternative utilisant le fait que le calcul est

exact pour un nombre de courant de 1. Dans ce cas en effet, le flux

est simplement le produit du flux de masse par la concentration

moyenne du traceur dans la maille amont.

Si le nombre de courant est plus grand que 1,

(pour fixer les idées, si on prend ![]() et

et

![]() )

on peut calculer le transfert de traceur comme la somme de la quantité

de traceur dans la maille amont (

)

on peut calculer le transfert de traceur comme la somme de la quantité

de traceur dans la maille amont (![]() ) et de la quantité

de traceur transférée depuis la maille

) et de la quantité

de traceur transférée depuis la maille ![]() avec un flux

de masse

avec un flux

de masse ![]() .

.

De façon générale, pour

|

(2.52) |

|

(2.53) |